Von Künstlicher Intelligenz zu erklärbarer künstlicher Intelligenz – von AI zu explainable AI

Zu Beginn dieses Beitrags geben wir eine kurze Einführung in das Thema Künstliche Intelligenz. Wir beleuchten die Frage, weshalb künstliche Intelligenz nicht in viel mehr alltäglichen Anwendungsbereichen genutzt wird. Die Frage führt uns zum Ansatz der „erklärbaren künstlichen Intelligence“ oder englisch explainable AI (XAI). Den Ansatz der Explainable AI stellen wir anhand von Beispielen vor und erläutern ihn. Zum Abschluss geben wir einen kurzen Abriss zum Einsatz von Explainable AI in der Praxis.

Bei der Unterstützung von Unternehmen zur Umsetzung von KI basierten Anwendungen, stellen wir immer wieder fest, dass die Identifikation eines geeigneten Anwendungsfalles im Vergleich zur technischen Umsetzung oftmals die größere Herausforderung ist. Die Definition des Anwendungsfalles schließt die Festlegung der Eigenschaften der zu erstellenden Lösung mit ein. Die folgenden Fragen zeigen beispielhaft welche Aspekte festgelegt werden müssen.

- Wer sind die Anwender der fertigen Lösung?

- Wieviel Hintergrundinformation benötigen die Anwender bei der Nutzung?

- Wie schnell muss ein Ergebnis geliefert werden?

- Soll das Ergebnis auch graphisch darstellbar sein?

- …

Gerade in diesem Kontext kann Explainable AI unterstützen, in dem die gewünschten Eigenschaften der KI-Lösung im Vorfeld abgefragt und festgelegt werden.

Künstliche Intelligenz ganz kurz und die Idee von erklärbarer KI

Künstliche Intelligenz (Artificial Intelligence, AI) beschreibt die Fähigkeit von Maschinen, nicht nur fest vordefinierte Abläufe auszuführen, sondern den zunächst festen Ablauf auf Basis von Erfahrungswerten und Berechnungen an den aktuellen Kontext anzupassen. So kann der Computer vermeintlich verstehen, intelligent reagieren und eigene Entscheidungen treffen. Die Anwendungsbereiche künstlicher Intelligenz werden immer breiter und vielfältiger. Eine Herausforderung dabei ist, dass die Entscheidungen des Computers nicht immer nachvollziehbar sind. Durch den Anwender kann also nicht nachvollzogen werden, aufgrund welcher Parameter oder Messwerte eine Entscheidung durch das Programm berechnet wurde. Dieses Manko stellt nicht selten einen Hinderungsgrund für die Nutzung von künstlicher Intelligenz dar.

Die Idee der erklärbaren KI, Englisch: explainable AI, hat das Ziel, die Akzeptanz für den Einsatz von künstlicher Intelligenz zu verbessern, indem die Nachvollziehbarkeit der Ergebnisse als Teil der Umsetzung gesehen wird.

Woher kommt der starke Push für Künstliche Intelligenz?

Künstliche Intelligenz ist in vielfältigen Formen bereits heute in das alltägliche Leben integriert. Der Begriff bezeichnet die Fähigkeit von Maschinen, kognitive Aufgaben auszuführen, die bisher von Menschen übernommen wurden. Etwa Aufgaben, die ein differenziertes Vorgehen erfordern, dass an den individuellen Kontext angepasst ist.

Obwohl erste Forschungen zu Artificial Intelligence (AI) bereits in den 1950er Jahren unternommen wurden, ermöglichten erst die Entwicklungen im Bereich Computerleistung, das Bestehen größerer Datenbanken sowie die wachsende Menge an Daten, den Durchbruch der Technologie. Die Entwicklung war in den letzten 10 Jahren rasant.

Heute können bereits viele Mobiltelefone eine Gesichtserkennung treffsicher und schnell durchführen. Gesichtserkennung ist ein klassisches Beispiel für den Einsatz von Künstlicher Intelligenz. Das Lernen der Programme erfolgt anhand historischer Daten des jeweiligen Anwendungsbereiches. Von den Vorteilen und Versprechungen künstlicher Intelligenz wollen immer mehr Unternehmen profitieren. Ein nachvollziehbarer Grund ist die Fähigkeit von maschinellem Lernen (Machine Learning), aus einer großen Menge Daten, Muster und Verhaltensweisen zu erkennen. Die Ergebnisse sind dabei im Vergleich zu simpleren, statistischen Analysen genauer. Sie erlauben zudem eine in die Zukunft gerichtete Prognose.

Und wir alle wissen, Prognosen sind schwierig, insbesondere wenn sie sich auf die Zukunft beziehen.

Letztlich besteht die Vorgehensweise solcher Anwendungen darin, die eingegebenen Daten mittels mathematischer Verfahren wiederholt neu zu gewichten, bis eine möglichst genaue Vorhersage ausgegeben werden kann.

Woran scheitert Künstliche Intelligenz in der Praxis?

Die Komplexität der Berechnungen ist hinsichtlich des Aufwandes und Menge der Einzelberechnungen hoch. Die Kosten für entsprechende Rechenleistung haben über lange Jahre eine technische Hürde für die breite Anwendung von Verfahren der Künstlichen Intelligenz dargestellt. Darüber hinaus waren die benötigten Trainingsdaten nicht in ausreichender Menge verfügbar. Ausreichende Verfügbarkeit von Trainingsdaten ist jedoch eine wesentliche Voraussetzung, um KI-Anwendungen zu erstellen, die in der Realität gute Ergebnisse erzielen.

Die beiden vorstehenden Motive sind in den letzten Jahren immer weiter in den Hintergrund getreten. Die Gründe hierfür sind die Verbreitung von „cloudbasierten“ und nach dem Verbrauchsprinzip mietbarerer Rechenzentren sowie die schnelle Verfügbarkeit von Trainingsdaten in verschiedenen Anwendungsbereichen durch die deutlich gestiegene Digitalisierung weiterer Bereiche des privaten und beruflichen Lebens.

Wenn diese Hürden heute nicht mehr in dem Maße bestehen, warum sind KI-Anwendungen dann nicht schon heute die neue Normalität?

Selbst, wenn die Berechnungslogik des erstellten Programms und alle genutzten Trainingsdaten im Detail bekannt sind, sind die Ergebnisse für neue Daten nicht notwendiger Weise extern nachvollziehbar.

Dieser „Black Box Charakter“ wird in der Praxis verstärkt, da die Endanwender weder das Computerprogramm noch die genutzten Trainingsdaten vollständig kennen. Diese Umstände stellen ein generelles Hemmnis für die Nutzung von Künstlicher Intelligenz dar. In besonderer Weise trifft dies in sensiblen Bereichen zu. Die folgenden drei Beispiele sollen die Spannweite exemplarisch vor Augen führen. Etwa im Finanzbereich, wenn ein Computerprogramm über die Vergabe von Krediten oder die Festlegung von Zinsen entscheidet.

Bei Produktvorschlägen im Online Shop sind Shop-Betreiber und Konsumenten im Vergleich unkritisch gegenüber den genauen Gründen für den Vorschlag eines grünen anstatt blauen T-Shirts.

Im Kontext einer KI gestützten Diagnose beim Arzt wird sehr viel mehr Wert auf die Genauigkeit und Erklärbarkeit des Ergebnisses gelegt.

Neben diesen gesellschaftlichen und ethischen Gesichtspunkten gilt es auch die juristischen Rahmenbedingungen zu bedenken. Auf nationaler und europäischer Ebene sind die Leitplanken für eine automatisierte Entscheidungsfindung durch das Bundesdatenschutzgesetz und die DSGVO geregelt.

Der Computer sagt nein

Das bekannte Zitat aus der englischen Comedy Serie „Little Britain“ bringt es auf den Punkt. Beantragt ein Kunde einen Kredit bei seiner Bank dessen Bewilligung abgelehnt wird, ist die Antwort des Bankmitarbeiters, „der Computer sagt nein“, für den Kunden als Antwort und Begründung sicher nicht ausreichend. Der Kunde möchte wissen, warum die Bank so entschieden hat.

In einem klassischen KI-Ansatz kann das Geldinstitut dem Kunden zwar sagen, dass ein automatisiertes Programm mit Verfahren der Künstlichen Intelligenz mit einer bestimmten Genauigkeit vorhersagt, dass der Kunde die Raten nicht zurückzahlen wird. Allerdings kann die Bank nicht darlegen, welche Daten und Eigenschaften für das getroffene Ergebnis maßgeblich verantwortlich sind. Ebenso könnte ein Arzt eine durch Künstliche Intelligenz empfohlene Diagnose nicht vollends begründen.

An diesen Beispielen zeigen sich die Schwächen der sogenannten Black-Box-Modelle: Für den Nutzer bleiben Entscheidungen undurchsichtig und die Kausalität des Modells kann nicht mehr überprüft werden.

Bist Du ein Wolf oder ein Husky?

Hierdurch kann es unbemerkt bleiben, wenn ein Datenmodell nicht relevante Eigenschaften mit in die Entscheidungsfindung einbezieht. Wie etwa bei einer Anwendung der Bilderkennung, die Wölfe und Huskys unterscheiden sollte. Das Modell wurde verifiziert und funktionierte mit den Trainingsdaten und neuen Bildern zunächst sehr zufriedenstellend. Mit der Zeit zeigte sich jedoch, dass die Entscheidung zwischen Wolf und Husky ganz wesentlich davon abhing, ob Schnee auf dem Bild war oder nicht. Sehr viele Bilder von Wölfen hatten Schnee mit im Bild. Die Bilder der Huskys waren meist ohne Schnee. Schnee ist jedoch für die Unterscheidung zwischen Wölfen und Huskys unerheblich.

Die Herausforderung in der Praxis

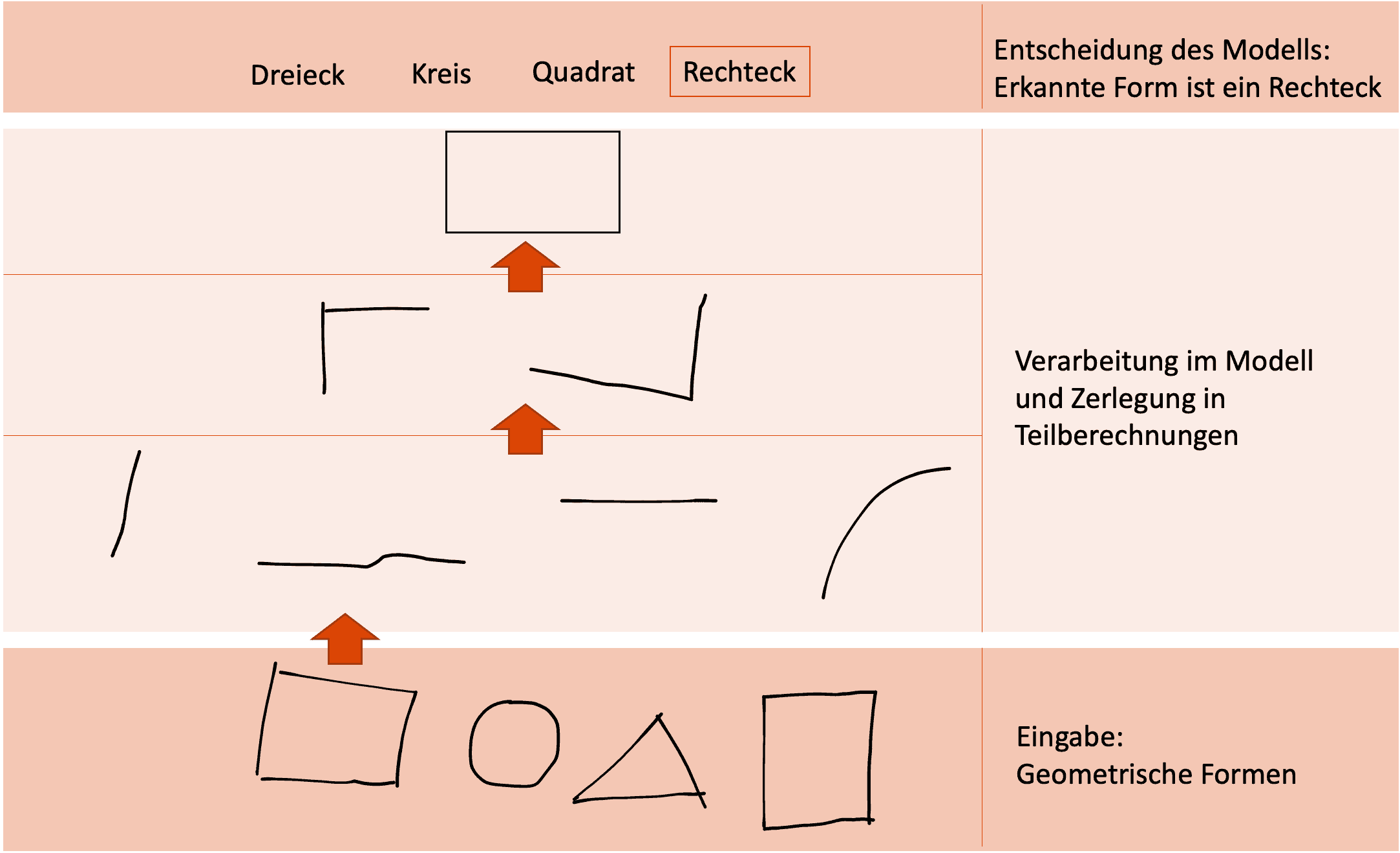

In der Praxis gestalten sich diese Machine-Learning-Prozesse also komplexer. Bei Anwendung des Deep Learning, einer Art des maschinellen Lernens, werden Schichten eingefügt, die versteckt Berechnungen durchführen. Die Daten werden in jeder Schicht verarbeitet und in verarbeiteter Form an die nächste Schicht weitergegeben. Durch diesen Ansatz können Berechnungen, die in einem Arbeitsschritt zu komplex sind, in viele kleinere Schritte unterteilt werden. In jeder einzelnen Schicht wird hierbei nur eine Teilaufgabe erledigt. Die zahlreichen Berechnungen sowie die große Menge an Daten können zu einer Herausforderung für die Gewichtung zwischen Genauigkeit und Interpretierbarkeit führen. Diese Herausforderung wird als „Accuracy-Interpretability Tradeoff“ bezeichnet. Dies wird dadurch verstärkt, dass das Hinzufügen zusätzlicher Schichten, sogenannten Hidden Layers, die Genauigkeit meist verbessert. Gleichzeitig erschwert jede Schicht aber die Nachvollziehbarkeit des Ergebnisses.

Zu viele Schichten verderben den Brei

In einigen Anwendungsbereichen und bei einigen Entscheidern ist dies ein Grund, vorerst auf den Einsatz von Künstlicher Intelligenz zu verzichten, da sie nicht in der Lage sind, die Entscheidung der Maschine nachzuvollziehen und zu begründen. Um die Erkenntnisse als auch den eigentlichen Vorgang der Künstlichen Intelligenz greifbarer zu machen, forschen Wissenschaftler an Methoden, die die Black-Box entschlüsseln und sie für jeden verständlich machen sollen.

Die Elemente von Explainable AI

Erklärbarkeit

Einer Umfrage von Gartner zufolge verhindert vor allem das fehlende Wissen von Mitarbeitern über maschinelles Lernen eine flächendeckende Adoption. So trauen sich viele ohne statistischen Hintergrund nicht zu, die Anwendungen richtig nutzen zu können. Entsprechend verlassen sie sich lieber weiterhin auf bewährte Modelle. Dadurch bleiben Möglichkeiten, die das maschinelle Lernen bietet, ungenutzt. Damit möglichst viele Anwender, vom Marketier bis zum Programmierer, verstehen können, wie und was der Computer gerade berechnet, hat die Forschung zur Explainable AI Modelle und Methoden zum Ziel, die eine grundsätzlich bessere Erklärbarkeit aufweisen. Die neuen Ansätze sollen die Komplexität der Black Box Modelle auflösen.

Menschen sollen in der Lage sein, die Funktionsweise von Künstlicher Intelligenz nachzuvollziehen und im besten Fall auch selbst anwenden zu können. Hierbei sollen Nutzung und Anwendung auch ohne tiefgehende statistische und informationstechnische Vorkenntnisse möglich sein. Nach dem Motto: Um mit einem Auto fahren zu können, ist keine Ausbildung als KFZ-Mechaniker oder ein Studium der Motorenentwicklung notwendig. Das Erlernen in der Fahrschule und Ablegen der Führerscheinprüfung sind ausreichend.

Computer können gut rechnen, Menschen besser interpretieren und die Ergebnisse in Relation setzen. Explainable Artificial Intelligence (XAI) möchte beide Stärken kombinieren und jeweils erweitern. Dafür ist es allerdings notwendig, dass deutlicher wird, was mit den eingegebenen Daten passiert. Während die ursprüngliche KI-Anwendung momentan nur ein Ergebnis liefert und dieses mit einer bestimmten Wahrscheinlichkeit rechtfertigt, können Methoden wie LIME (Local Interpretable Model-agnostic Explanations) bei einzelnen Fällen herausstellen, welche Attribute für die jeweilige Entscheidung relevant waren. Dadurch werden die Stärken von einfacheren Modellen wie der Linearen Regression aufgenommen und mit den adaptiven Ergebnissen zusammengelegt. Dem Menschen ermöglicht dies, die Kausalität der maschinellen Entscheidung zu überprüfen.

Datenschutz Rechtfertigung und Transparenz in der KI

Nicht zuletzt ist das Vertrauen in das Machine Learning wichtig. Dazu gehört neben der bereits genannten Erklärbarkeit des Ergebnisses auch die Rechtfertigung der verwendeten Daten. Wie weiter oben erwähnt, definiert die Datenschutzgrundverordnung (DSGVO), dass jeder Nutzer das Recht hat, die Nutzung seiner Daten für automatisierte Anwendungen zu hinterfragen. Unternehmen müssen nun also in der Lage sein, auch solche Anfragen beantworten zu können. Im Rahmen sich weiter verschärfenden Regulierungen wird das Verständnis für Künstliche Intelligenz so immer mehr zur Pflicht.

Die Anwendung von Explainable AI

Als nächster Schritt im Bereich Machine Learning soll Explainable AI vor allem die menschliche Komponente der Mensch-Maschine-Interaktion ansprechen. Nachdem Künstliche Intelligenz bei der Geschwindigkeit der Datenverarbeitung bereits Überzeugungsarbeit geleistet hat. Hierbei geht es nicht nur um Erklärbarkeit gegenüber Endkunden wie im Beispiel der Kreditvergabe. Gemeint ist auch die Erklärbarkeit für die Anwendung im Unternehmen.

Für die Erstellung der KI-Anwendung ist spezifisches Fachwissen unerlässlich. Gleichzeitig sollte es nicht Voraussetzung sein, dass man den verwendeten Algorithmus von Grund auf selbst implementiert haben muss, um das Modell zu verstehen. Daher wird heute für die Planung einer KI-Anwendung im Vorfeld eine Befragung der späteren Anwender durchgeführt. Das Ergebnis der Befragung kann die Unterschiede der möglichen Lösungsansätze aufzeigen sowie Präferenzen der späteren Anwender darstellen.

Die Umsetzung neuer Anwendungsfälle sollte durch eine Softwarelösung soweit geführt sein, dass das erstellte Modell die Anforderungen an erklärbare Künstliche Intelligenz erfüllt.

Um nur zwei Punkte aufzugreifen:

- Soll das fertige Modell visuell darstellbar sein?

- Wird mehr Gewicht auf Schnelligkeit oder Genauigkeit gelegt?

Fazit

Mit unserer Expertise unterstützen wir Unternehmen bei der Umsetzung von KI basierten Anwendungen. Hierbei legen wir insbesondere Augenmerk auf die Konstellation der späteren Nutzung des Modells, um eine hohe Akzeptanz zu erzielen. Die Orientierung an anwenderfreundlichen Methoden sowohl aus der klassischen als auch aus der Explainable AI Forschung hat sich als sehr zielführend erwiesen.

Zur Sicherstellung des Erfolges beim Einsatz von KI sowohl für das Unternehmen, das die KI einsetzt, als auch für die eigentlichen Nutzer der KI ist Transparenz ein essenzieller Faktor. Ein AI Manifest wie das von REWE ist sicher sehr hilfreich, und daher aus unserer Sicht sehr zu begrüßen.

Gerne beraten wir Sie bei den Möglichkeiten zum Einsatz von maschinellem Lernen in Ihrem eigenen Unternehmen. Sprechen Sie uns an!

Links

Bundesdatenschutzgesetz: https://dejure.org/gesetze/BDSG/31.html

DSGVO: https://dejure.org/gesetze/DSGVO/22.html

LIME: https://github.com/marcotcr/lime

REWE AI Manifest: https://ai-manifesto.rewe-digital.com/de/

Feedback

Wir freuen uns über Feedback und weiteren Austausch zum Thema Explainable AI.