Die Verbreitung von digitalen Sprachassistenten nimmt stetig zu. Die Datenanalyse digitaler Sprachassistenten wird damit zu einem zunehmend wichtigen Thema in vielen Unternehmen.

Dabei sind die digitalen Sprachassistenten aus zwei Gründen für die meisten Unternehmen ein neuer und recht unbekannter Kommunikationskanal:

Zum einen durch ihre Eigenständigkeit in der Nutzerführung und zum anderen durch die Eigenständigkeit der technischen Basis.

Die Erfassung von Nutzungsdaten der Sprachassistenten kann hingegen durch die Anwendung bestehender Prozesse und auf Basis vorhandener Technologie umgesetzt werden. Mit dem Artikel wollen wir einen Einblick in die Unterschiede der Plattformen und die Möglichkeiten zur Datenanalyse von digitalen Sprachassistenten geben.

Verbreitung von digitalen Sprachassistenten

„Alexa…“, „Ok Google…“, „Hey Siri…“ schallt es durch Wohnzimmer, Schlafzimmer und selbst in der Bahn – Sprachassistenten haben sich in kurzer Zeit in vielen Haushalten etabliert. Nach einer Studie der Postbank aus Juni 2019 nutzen bereits 32 Prozent der Deutschen einen digitalen Sprachassistent.

Damit sind Sprachassistenten zu einem weiteren und zunehmend wichtigen Kommunikationskanal geworden. Die Analyse der Nutzung mittels eines geeigneten Analysekonzept ist wichtig, um die technische Leistungsfähigkeit des Dienstes und die Zufriedenheit der Nutzer zu verstehen.

Denn ein weiterer Touchpoint mit Kunden und Interessenten bedeutet: Neue Möglichkeiten zur Interaktion, Akquise und Kundenbindung. Aber auch: Ein weiterer Medienbruch und eine weitere Möglichkeit, Kunden durch eine schlechte Nutzererfahrung zu verlieren.

Den Erwartungen an Alexa, Siri und Assistant gerecht werden

Unsere Analyse zeigt, dass sich Nutzer mitunter bei der Nutzung der Assistenten „verirren“. Dies liegt daran, dass die Kommunikation mit einem Sprachassistenten jederzeit offen ist. Nutzer in einer Shopping-App fragen beispielsweise nach dem Wetter oder dem Abspielen von Musik. Bleibt hierauf eine passende Antwort aus oder wird ein simples „Das weiß ich leider nicht“ vom Assistenten zurückgegeben, sinkt die Zufriedenheit des Nutzers oft rapide und es kommt mitunter zu regelrechter Kritik. In manchen Fällen sogar zu Aggression gegenüber dem Assistenten. „Google bilde Dich weiter und lese ein Lexikon“, ist für einen solchen Fall noch eine harmlose Aussage.

Teil einer digitalen Marketingstrategie muss es daher sein, die Nutzerfahrung unter Zuhilfenahme von Analytics über alle genutzten Kanäle hinweg zu verstehen und zu optimieren. Für viele Unternehmen besteht eine Herausforderung darin, dass die genutzten Kanäle wie Web, App, Social Media und zunehmend Voice Assistants je nach Branche und Welt-Region unterschiedlich gewichtet sind. Im internationalen Kontext müssen die Kanäle in mehreren Sprachen unterstützt werden. Zu allem Überfluss bleiben die Kanäle nicht konstant. Nach wie vor kommen neue Kanäle hinzu, andere nehmen an Bedeutung ab.

Vorbehalte in Bezug auf Datenschutz und Privatsphäre der Nutzer ernst nehmen

Wenngleich viele Nutzer aufgrund des zusätzlichen Komforts digitale Assistenten bereitwillig an intimsten Orten wie Wohnzimmer, Schlafzimmer oder Bad lauschen lassen, herrscht weiterhin eine gewisse Skepsis gegenüber den digitalen Helfern. Eine Skepsis, die etwa zu Fragen wie „Was ist der Unterschied beim Abhören durch Google und der Staatssicherheit der DDR“ an den Assistenten führt.

Vertrauen kann nur geschaffen werden, wenn der Nutzer weiß, welche Informationen erfasst werden, und aus welchem Grund. Transparenz und Vertrauen sind wichtige Aspekte, die Marken strikt beachten sollten.

Neben dem eigenen Verhalten einer Marke ist die Reputation der Plattform, über die der Sprachassistent bereitgestellt wird, beachtenswert. Für den Anwender ist die Nutzung der Sprachassistenten stark mit den Technologieanbietern Amazon, Google, Apple, Microsoft oder Samsung verbunden. Ein individueller Sprachassistent wird innerhalb der Plattform bereitgestellt. Hierdurch entstehen eine direkte technische Verbindung und Abhängigkeit zwischen dem Assistenten und der Plattform. Sinkt das Vertrauen der Nutzer in die Plattform z.B. durch Bekanntwerden von Datenmissbrauch, hat dies potenziell negative Ausstrahlung auf die eigene Marke. Denn der Nutzer differenziert ggf. nicht mehr zwischen technischer Plattform und den darin angebotenen Diensten.

Bevor die technischen Aspekte des Voice Trackings betrachtet werden, gilt es daher insbesondere, dem Nutzer gegenüber transparent zu machen, dass Informationen erfasst werden, und zu welchem Zweck die Information genutzt wird. Für Personen bezogene Daten erfordert die Erfassung ein aktives Opt-In. Bei Erfassung statistischer Daten muss die Möglichkeit zum Opt-Out gegeben sein.

Unterschiede der Sprachassistenten von Amazon, Apple, Google und Co.

Die technischen Plattformen, die den Sprachassistenten zugrunde liegen sind sehr unterschiedlich. Die einen erlauben es Dritten eigene sprachgesteuerte Assistenten zu entwickeln. Diese werden bei Amazon als „Skill“ bezeichnet. Bei Google werden individuellen Anwendungen „Action“ genannt.

Die anderen Plattformen erlauben das Erstellen eigenständiger Voice Apps nicht. So übernimmt bei Apple’s Siri das Betriebssystem die zentrale Steuerung. Die Anpassung erfolgt durch den Nutzer selbst. Denn er kann eigenständig einen individuellen Assistenten durch Anlegen über Kurzbefehle erstellen. Dies wird häufig auch als „If-this-than-that“ (IFTTT) Anwendung bezeichnet. Hierbei müssen die jeweiligen Apps das Erstellen von Kurzbefehlen unterstützen, damit der Nutzer diese gezielt in seinen Assistenten einbinden kann.

Doch was können die Sprachassistenten überhaupt? Auf der einen Seite schon erstaunlich viel, auf der anderen Seite erschreckend wenig. Sprachassistenten können gut einzelne Geräte steuern, z.B. eine Leuchte ein- und ausschalten. Das Stichwort hier ist Smart Home. Was sie noch nicht gut können, ist den Kontext erfassen in der die Nutzung stattfindet. Das Bearbeiten einer Einkaufsliste und beiläufiges Einschalten des Lichtes ist für die Assistenten (noch) schwierig.

Smart Home und Sprachassistenten stehen in enger Verbindung.

Die folgende Tabelle zeigt eine Übersicht der Plattformen der verschiedenen digitalen Sprachassistenten.

| Sprachassistent | Anbieter / Plattform | Anbieter eigene Dienste | IFTTT | Plattformen / Geräte |

| Alexa | Amazon | Skill | Nein | Echo, Echo Dot, Echo Show,Echo Spot |

| Siri | Apple | Homekit | Ja | Alle aktuellen Apple Geräte |

| Google Assistant | Action | Ja | Verschiedene Google Geräte, iOS | |

| Bixby | Samsung | Capsules | Ja | Samsung Geräte |

| Cortana | Microsoft | Skill/Bot | Ja | Windows 10, Xbox, Android, iOS |

Die Art der Interaktion ist stark abhängig von dem Endgerät, über das der Dienst benutzt wird. Die Bandbreite umfasst Geräte mit und ohne Bildschirm oder Tastatur, stationäre, sowie mobile Geräte. Genauso divers wie die Geräte sind die Nutzungssituationen. Etwa im Badezimmer, in der Küche oder Wohnzimmer. Aber auch beim Sport oder im Auto.

Praktische Umsetzung der Datenerfassung für digitale Sprachassistenten

Die technische Umsetzung eines individuellen Sprachassistenten ist stark von der Plattform abhängig für die der Assistent erstellt wird. So können beispielsweise für Siri von Apple keine eigenen Applikationen erstellt werden wie etwa für Amazon Alexa oder Google Assistant.

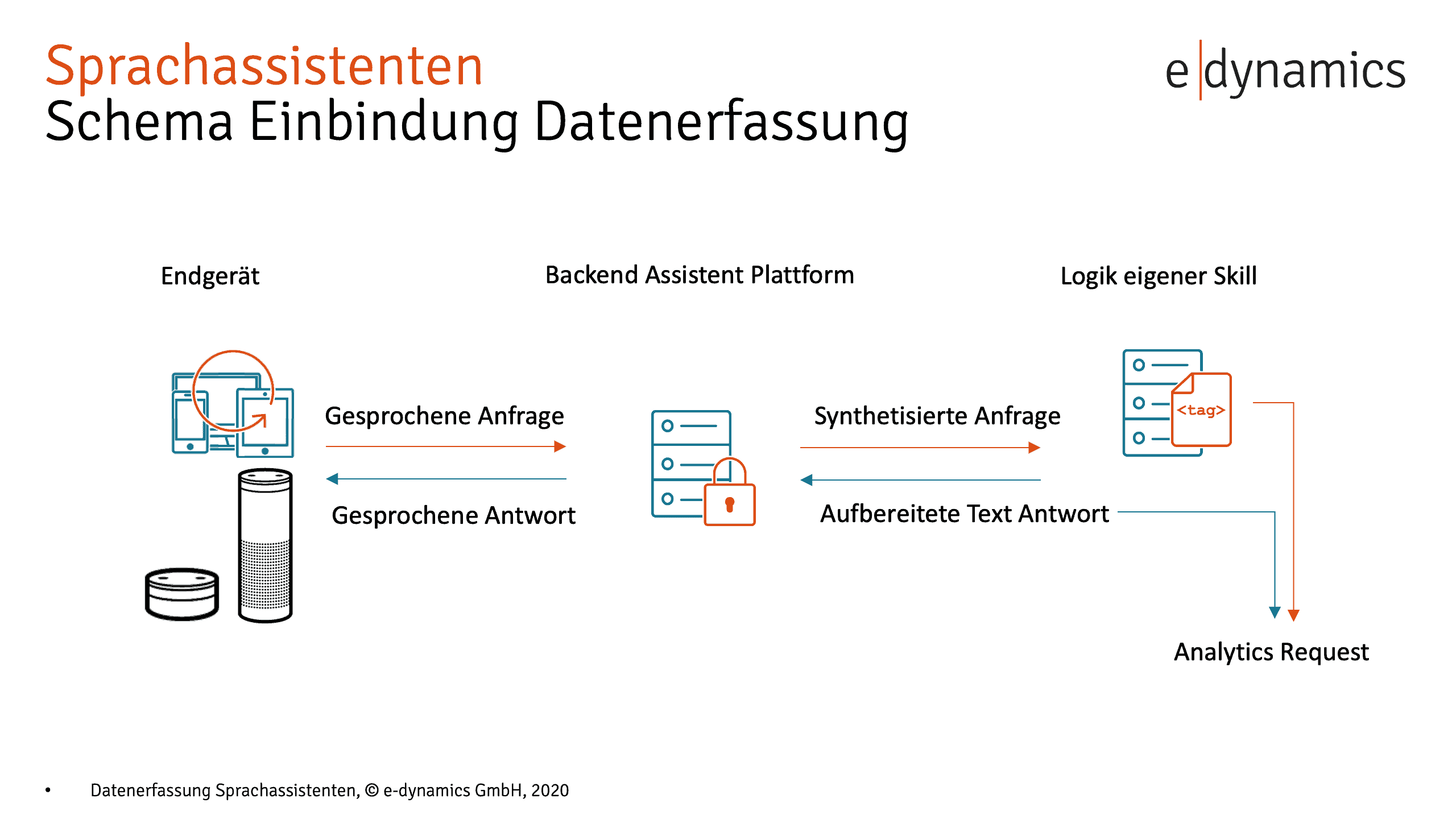

Die Logik der Skills wird in der Regel nicht auf dem Gerät ausgeführt, an das der Nutzer seine Anfrage gestellt hat. Gesprochene Nutzeranfragen werden digitalisiert und an die Assistant Plattform geschickt. Dort werden sie verarbeitet, und die erkannten Parameter an den jeweils passenden Skill weitergeleitet. Der Skill verarbeitet die Anfrage entsprechend der empfangenen Daten, und liefert die Antwort wiederum an die Assistant Plattform. Die Assistant Plattform generiert die Antwort und liefert sie an das anfragende Gerät aus. Auf dem Gerät selbst wird kein selbstdefinierter Code ausgeführt. Das heißt: die Datenerfassung für die spätere Analyse kann nicht auf dem Gerät des Anwenders stattfinden, sondern muss im Backend des jeweiligen Skills geschehen. Die folgende Grafik erläutert den zuvor beschriebenen Ablauf.

Aktuell gibt es noch wenige Analytics SDKs, für die Verwendung im Kontext der Assistant Plattformen. Für Adobe Analytics müssen die Tracking-Requests für jede Interaktion selbst zusammengesetzt werden. Dies erlaubt auf der einen Seite eine hohe Flexibilität birgt gleichzeitig Herausforderungen bei mangelnder Erfahrung für die Erstellung von Trackingkonzepten und Solution Design Dokumenten. Aufgrund der fehlenden festen, technischen Vorgaben eines SDK, ist die Beachtung der individuell definierten Umsetzung nach dem Trackingkonzept besonders wichtig.

Zur Verbesserung der eigenen Skills sollten insbesondere die Anfragen analysiert werden, auf die der Skill keine Antwort geben konnte – dies bedeutet jedoch, jedes an den Skill gerichtete Wort anonymisiert zu erfassen.

Sprachlich verschieden formulierte Nutzeranfragen können die gleiche Bedeutung haben und somit denselben „Intent“ ansprechen. Diese Anfragen sollten im Tracking sinnvoll gruppiert werden, um besonders gut funktionierende Teilbereiche eines Skills ausfindig zu machen.

Andere Anfragen führen eventuell zu Fallback-Lösungen wie „Das kann ich leider nicht beantworten“. Hier ist es sinnvoll, den Wortlaut der Anfrage zu analysieren. Anfragen, die häufig fehlschlagen sollten in das Portfolio des Skills aufgenommen werden, um die Nutzererfahrung zu verbessern und potenzieller Frustration bei den Anwendern vorzubeugen.

Auch das Debugging der Datenerfassung für Voice Assistants gestaltet sich komplexer als im Kontext eines Web-Angebotes. Eine Anwendung im Browser und eine App lassen sich mittels Proxy Server recht einfach und dezentral debuggen. Hingegen wird zum Debuggen der Datenerfassung von Voice Assistants der Zugriff auf den jeweiligen Server benötigt, der den Skill bereitstellt.

Erkenntnisse aus der Datenanalyse der digitalen Sprachassistenten

Der Workflow für die Umsetzung einer wohldefinierten Datenerfassung eines Sprachassistenten weicht von denen bekannten Abläufen im Kontext von Browser-Anwendungen oder native Apps ab. Gleichwohl können die Daten in der Struktur so erfasst werden, dass sie zielgerichtet in der Web Analyse Umgebung ausgewertet werden können. Die Umsetzung der Datenerfassung für Sprachasssistenten begründet nicht die Notwendigkeit für eine separate Analyseumgebung.

Die Analyse der Daten stellt aus unserer Sicht einen hohen Wert dar, da die Daten gute Rückschlüsse auf die Intention der Nutzer zulassen. Das Verständnis der Nutzung eines Sprachassistenten ist damit ein wichtiger Baustein für eine kundenorientierte Ausrichtung und Customer Centricity.

Ist dieses Thema für Ihr Unternehmen interessant oder haben Sie weitere Fragen zur Datenanalyse digitaler Sprachassistenten? Dann melden Sie sich gerne direkt bei uns.